【导读】在本研究中,团队开发了一个多模态AI模型(联合AI模型),并对前瞻性数据集,进行了交叉试验,以评估该模型协助内窥镜医师诊断胰腺病变的能力,以及未来临床应用的优势和潜在路径。

2024年7月19日,中国医学科学院协和医院胃肠病科杨爱明团队在期刊《JAMA》上发表了题为“Diagnosing Solid Lesions in the Pancreas With Multimodal Artificial Intelligence: A Randomized Crossover Trial”的研究论文。本研究通过开发融合临床信息和EUS图像的多模态AI模型,推进胰腺实性病变的临床诊断。

https://jamanetwork.com/journals/jamanetworkopen/fullarticle/2821351?resultClick=1

研究背景

01

胰腺癌是胰腺肿块的常见原因,总体5年生存率约为10%。超声内窥镜(EUS)已成为诊断胰腺癌的宝贵技术,对计算机断层扫描和磁共振成像,具有卓越的敏感性,特别是对于直径小于3cm的肿瘤。然而,其他恶性较小的肿瘤(如胰腺神经内分泌肿瘤或实体假状肿瘤)和良性胰腺疾病(如慢性胰腺炎和自身免疫性胰腺炎)也可表现为胰腺肿块。由于胰腺癌的治疗和预后,与其他病变有很大不同,因此,准确的诊断至关重要。然而,EUS在区分恶性肿瘤和良性肿块方面的特异性并不理想,范围为50%-60%。尽管EUS引导下的细针穿刺或活检(EUS-FNA/B)显著提高了整体诊断准确性,达到了80%-90%的可靠水平和92%-99%的特异性,但对该技术相对低且不稳定的敏感性和阴性预测值(NPV)的担忧仍然存在,敏感性在80%-89%之间,NPV在46%-75%之间。

近年来,人工智能(AI)模型在肿瘤学领域显示出潜力,有助于筛查、诊断、治疗指导和预后预测。对于医学图像分析,卷积神经网络(CNN)是应用最广泛的深度学习算法之一。尽管CNN模型在EUS图像中显示出区分胰腺癌的前景,但先前的研究主要缺乏外部验证,阻碍了临床转化的途径。现有的深度学习模型只在单一模式上运行,忽略了其他方面的潜在诊断效果,如病史、实验室检查和放射学结果。整合多种模式,可能会提高诊断模型的稳健性。预计多模态人工智能模型,将比使用单一模态的模型更适用于临床实践。

在本项研究中,团队开发了一个多模态AI模型,使用EUS图像和临床信息,来区分癌与非癌性病变,并在内部、外部和前瞻性数据集中,测试了该模型。团队还评估了该模型在交叉试验中的辅助潜力,并检查了可解释性分析,是否可以促进临床应用。

研究进展

02

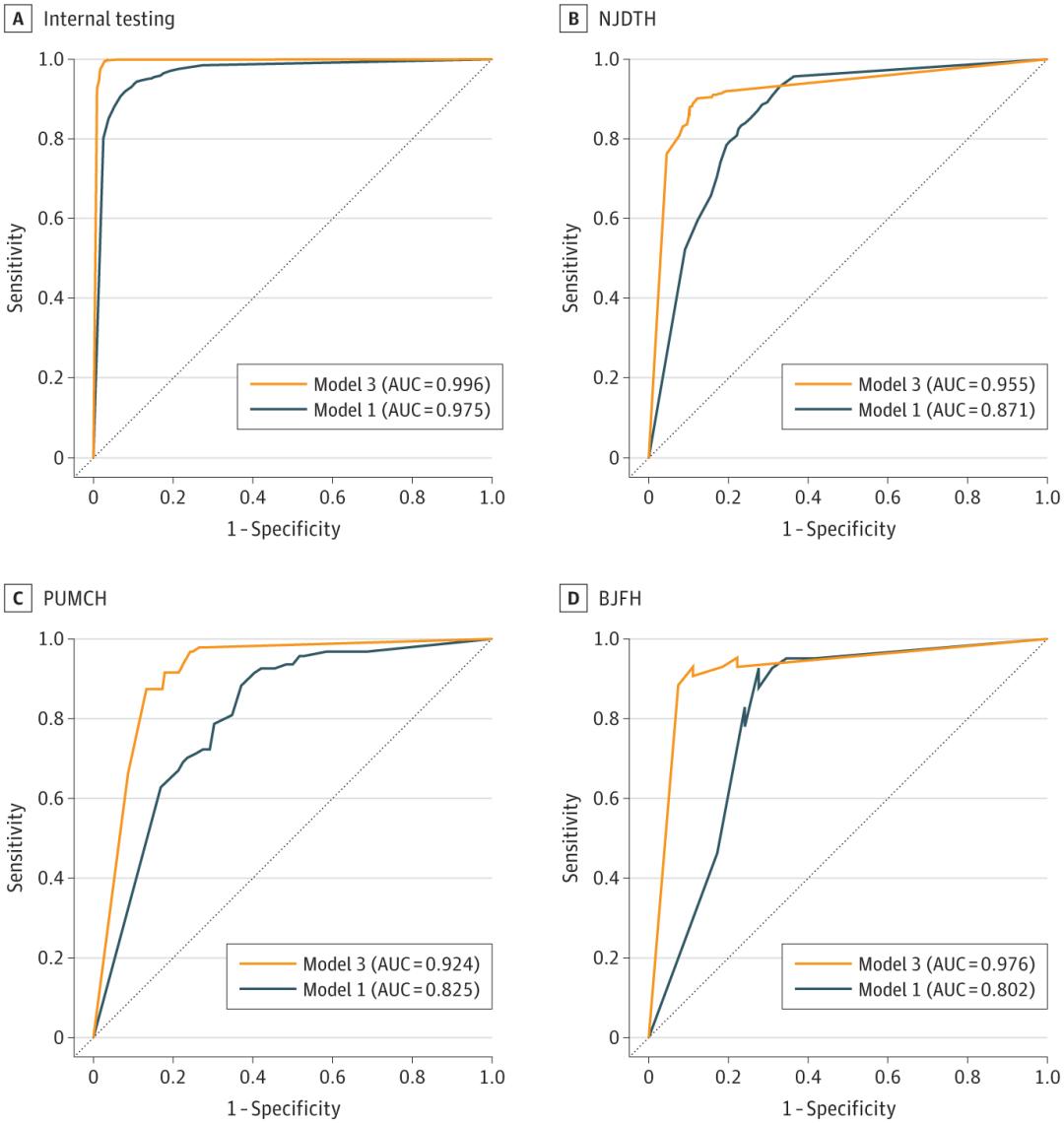

对于内部测试,模型1在图像阶段实现了0.975(95%CI,0.969-0.981)的AUC。然而,模型1在外部测试数据集中的AUC较低,介于0.802(95%CI,0.648-0.941)和0.871(95%CI,0.848-0.892)之间。

团队旨在通过整合相关临床信息,来增强模型的可推广性。团队采用多种机器学习算法,从不同类别中筛选出显著的临床特征,并根据其诊断准确性,从原来的36个特征中提取24个特征。在模型3的开发过程中,团队比较了3种数据融合策略的诊断性能。在图像阶段,策略B实现了0.996(95%CI,0.993-0.998)的最高AUC,准确率为0.98(95%CI,0.98-0.99)。同样,策略B在患者期,实现了最高的AUC。

人工智能模型在区分癌和非癌性病变方面的表现。

基于策略B构建的模型3,团队在外部测试数据集上,进行了进一步评估。在影像阶段的准确度为0.84(95%CI,0.79-0.87)至0.89(95%CI,0.87-0.91),在患者阶段的准确度为0.84(95%CI,0.74-0.91)至0.91(95%CI,0.73-0.98)。与单模态模型1相比,模型3表现出更强的性能。在图像阶段,与模型1相比,模型3的NJDTH的AUC显著增加(0.955 [95% CI,0.940-0.968] vs 0.871 [95% CI,0.848-0.892];P < .001)、PUMCH (0.924 [95% CI, 0.888-0.955] vs 0.825 [95% CI, 0.783-0.868];P < .001)和BJFH (0.976 [95% CI, 0.942-0.995] vs 0.802 [95% CI, 0.648-0.941];P < .001)。同样,模型3在患者阶段的表现,优于模型 1。

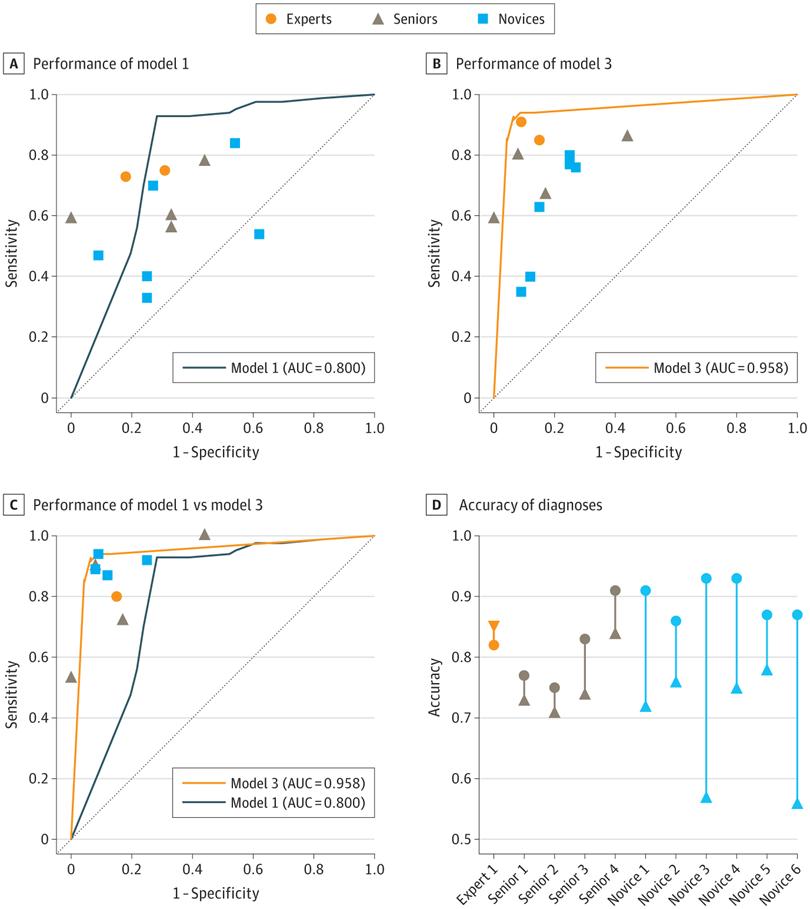

团队进行了一项前瞻交叉试验,以进一步评估人工智能模型的性能和辅助能力。当仅提供EUS图像时,模型1的表现优于内窥镜医生,后者(0.74 [95% CI,0.59-0.85])比专家内镜医生(0.93 [95%CI,0.85-0.97];P = .02)、高级内镜医师(0.62 [95%CI,0.50-0.73];P < .001)和新手内镜医师(0.56 [95%CI, 0.46-0.66];P < .001)更敏感 。当诊断基于临床信息和EUS图像时,模型3在诊断性能方面,仍然优于模型1。模型3比高级内镜医师更敏感 (0.92 [95%CI, 0.84-0.96] vs 0.72 [95% CI, 0.61-0.82];P = .002),比高级内镜医师更准确(0.92 [95% CI,0.86-0.96] vs 0.77 [95% CI,0.68-0.84];P = .001)。它也比新手内镜医师更敏感(0.61 [95%CI,0.51-0.70];P < .001),比新手内镜医师更准确 (0.69 [95% CI, 0.61-0.76];P < .001)。在AI的额外协助下,新手内窥镜医师的敏感性(0.91 [95%CI,0.83-0.95];P < .001)和准确度(0.90 [95%CI, 0.83-0.94];P < .001)显著提高。然而,专家和高级内窥镜医师,并未从人工智能辅助中受益。专家和高级内镜医师的总排斥率,显著高于新手内镜医师(比值比,2.15 [95%CI,1.12-4.16];P = .02) 。专家和高级内镜医师的总排斥率,达到了与新手内镜医师相当的水平(比值比,0.71 [95%CI,0.32-1.58];P = .40)。相应地,团队还观察到错误剔除率的降低。

团队向本研究的参与者,发送了一份调查问卷。与EUS-CNN模型相比,联合AI模型对内窥镜医师诊断的平均(SD)影响更高,并且更受欢迎(3.46 [0.69] vs 2.54 [0.93];P = .06) 。

内窥镜医师和人工智能模型在交叉试验中的诊断性能

研究结论

03

联合AI模型具有多项优势:

1.多模态性质。与之前主要构建仅对EUS图像操作的单模态模型的研究相比,联合AI模型结合了EUS图像和来自多个方面的临床信息。在整个训练过程中,临床和图像特征之间的相互关系不断完善,从而显著提高了性能。

2.可推广性。团队在3个独立中心招募了189名患者,以构成外部验证集。该模型在包含来自2家医院的130名患者的前瞻性数据集中,仍然具有稳健性。

3.它与临床工作流程保持一致。现有的用于胰腺病变分类的人工智能模型,主要关注计算机断层扫描或EUS图像。通过结合EUS图像和临床数据,来模拟临床决策过程,联合AI模型有可能轻松集成到临床工作流程中。

团队建议临床转化,有两个主要方向。首先,联合人工智能模型在不同数据集中,始终表现出强大的灵敏度(0.88-0.99)和NPV(0.86-0.99)。该模型的高灵敏度和净现值,可能通过为EUS-FNA/B提供可靠的补充信息,具有重要的临床意义。这些信息最终可能使临床医生能够在病理结果不确定的复杂情况下,做出明智的决定。

其次,鉴于EUS检查的深度学习曲线,以及缺乏标准化和充分的培训程序,内窥镜医生的诊断能力差异很大,尤其是对于经验不足的人。内窥镜医师与联合AI模型之间的相互作用,可能会改善这种情况。尽管如此,深度学习模型的黑匣子性质一直受到质疑,这可能会阻碍其临床应用。对于未来的临床应用,可解释性分析的结果和预测,应同时由人工智能模型报告。由于临床医生可以验证AI模型的预测,是否基于EUS图像和临床特征的正确方面,因此,他们更有可能接受模型的预测。此外,临床医生可以参与模型的推理,并将其用作支持决策过程的补充工具,而不是将模型视为黑匣子。

在这项诊断胰腺实体病变的随机交叉试验中,人工智能辅助诊断过程显著提高了新手内窥镜医师的表现,而可解释性分析提高了更有经验的内窥镜医师对人工智能预测的接受度。未来,这种联合人工智能模型在决策过程中具有更高的透明度,有可能促进胰腺实体病变的诊断。

参考资料:

1.Cai J, Chen H, Lu M, et al. Advances in the epidemiology of pancreatic cancer: trends, risk factors, screening, and prognosis. Cancer Lett. 2021;520:1-11.

2.Kitano M, Yoshida T, Itonaga M, Tamura T, Hatamaru K, Yamashita Y. Impact of endoscopic ultrasonography on diagnosis of pancreatic cancer. J Gastroenterol. 2019;54(1):19-32.